Seriously, Thanks for Not Stealing My Avocados

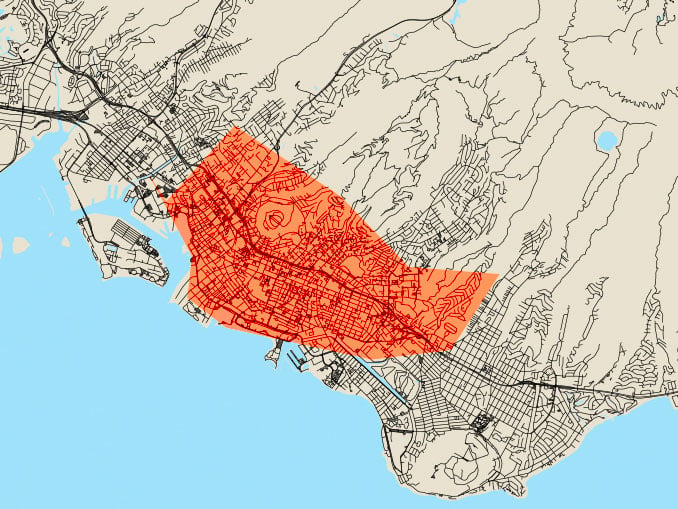

Counting the fruits of my avocado tree has become my obsession.

Two or three times a week I’m in the backyard, counting the avocados on my tree. It’s not easy. The tree is 30 feet tall and the fruits are the same shape and glossy green as the leaves, which flit in the breeze and throw sun sparkles in my eyes. I get a different count every time—28? 38? It doesn’t really matter. What matters is there are avocados on the tree, and if you know the story of my tree, you might be counting, too.

Image: iStock/Getty Images Plus, cuttlefish84, composite by James Nakamura

So I’ve become a little possessive. Every other summer, I stand under the tree and consider writing my name on the biggest fruits.

It’s an old tree that fruits every other year. When I was a child, my grandfather tied a swing to its lowest branch for me and my sister to play on. In late summer, he sliced open the sweet, creamy orbs for us and sprinkled them with brown sugar.

Thirty years later, I came home to this house and fell in love with the tree all over again—because people were stealing the avocados. One time I tiptoed across the yard and said hi to a man who was intently aiming his picker through the leaves (the suspect was skinny, with salt-and-pepper hair, and polite). Another time I thundered out of the house and across the yard (no description; she ran away before I could say hi). I even caught my grouchy old neighbor in the act (“Thank God it’s you!” I yelled out the window. “I was just about to call the police!”).

So I’ve become a little possessive. Every other summer, I stand under the tree and consider writing my name on the biggest fruits. They still might get stolen, but this way the thief would know I know. I never have, though. What would the neighbors think, seeing me climb a ladder with a Sharpie?

But now things have changed. I don’t care anymore. Last year, freak winds blew off nearly all the yellow blossoms that crown the tree in early spring. We had plans for that fruit. All the people who waited with us—Mr. Nago across the street, my cousin Rodney, James from Joy of Sake, Dad’s doctor’s little girl and so many others—lost the pleasure of those prized treats, and we lost the pleasure of giving them. Last year, we got two avocados from a tree that normally produces 200 to 300. That’s right, I counted.

Last year was a seismic season in my avocado-verse. For the first time, an odd-numbered summer went by without the swish-and-thunk of avocados falling through leaves to the grass below. For me, it’s always been a happy sound, especially in the long, quiet hours when insomnia keeps me up; then it’s a secret between me and the tree.

Some years, up to 14 fruits would fall in a day and send my guacamole production into overdrive (the recipe for Mari’s Should-Be-World-Famous Guacamole is posted on frolichawaii.com—search “Keep Your Picker Out of My Tree”). Those years I forced avocados on people who didn’t even want them. I would have been happy to share with my would-be thieves, too, had they only asked. Just holler next time.

So this year, we fertilized, and it’s going on three years that I’ve been waiting. Not only am I writing my name on every avocado I can reach, I’m writing the names of everyone who’s been waiting with me. Twenty-eight? Thirty-eight? Every single one is spoken for.

But I know there are a few more up there. They’re on the highest branches, in the most sun-blinded spots. And in the one corner I’ve been avoiding since I discovered a bird’s nest and startled the parents into shrieking flight. So if you love avocados, shoot me a line—if I find any extra, I’ll write your name on one, too.